AI가 우리 삶에 깊숙이 자리 잡은 지금, 나만의 AI를 직접 만들어보고 싶다는 생각, 한 번쯤 해보셨을 겁니다. 하지만 복잡한 과정과 어려운 기술 용어에 지레 겁먹고 포기하는 경우가 많습니다. 10년 넘게 IT 현장에서 기술 문서를 작성해온 경험을 바탕으로, 누구나 쉽게 따라 할 수 있는 ‘Ollama로 나만의 ChatGPT 만들기’ 방법을 안내해 드리고자 합니다.

Ollama가 무엇일까요?#

Ollama는 간단히 말해, 여러분의 개인 컴퓨터에서 강력한 대규모 언어 모델(LLM)을 손쉽게 실행할 수 있도록 도와주는 도구입니다. 인터넷 연결 없이도, 외부 서버를 거치지 않고도 AI 모델을 사용할 수 있어 보안이 중요한 데이터를 다루거나 오프라인 환경에서 AI를 사용하고 싶을 때 매우 유용합니다. 마치 내 컴퓨터에 직접 ChatGPT를 설치하는 것과 같다고 생각하시면 이해하기 쉽습니다.

다양한 오픈소스 LLM을 지원하기 때문에, 사용자는 필요에 따라 원하는 모델을 선택하고 교체하며 사용할 수 있는 높은 자유도를 자랑합니다.

왜 Docker Compose를 사용해야 할까요?#

Docker는 애플리케이션을 신속하게 구축, 테스트 및 배포할 수 있는 컨테이너 기술입니다. 특히 Docker Compose를 사용하면, Ollama와 사용자 친화적인 웹 인터페이스(WebUI)처럼 여러 서비스로 구성된 애플리케이션을 하나의 파일로 간단하게 정의하고 실행할 수 있습니다.

- 간편한 설치: 복잡한 설치 과정 없이, 명령어 한 줄로 필요한 모든 것을 한 번에 설치하고 실행할 수 있습니다.

- 독립된 환경: 내 컴퓨터의 다른 프로그램과 충돌 없이 독립된 환경에서 Ollama를 운영할 수 있어 안정적입니다.

- 쉬운 관리: 업데이트나 삭제가 매우 간편하여 유지보수가 용이합니다.

Ollama 설치하기#

이제 본격적으로 나만의 AI를 만들어 보겠습니다. 차근차근 따라오시면 결코 어렵지 않습니다.

Docker와 Docker Compose 설치하기#

Ollama를 Docker Compose로 설치하기 위해서는 당연히 Docker와 Docker Compose가 먼저 설치되어 있어야 합니다.

docker-compose.yml 파일 작성하기#

설치가 완료되었다면, 이제 Ollama와 웹 인터페이스를 함께 실행하기 위한 설정 파일을 작성할 차례입니다. 원하는 위치에 새로운 폴더를 하나 만드신 후, 그 안에 docker-compose.yml 이라는 이름으로 파일을 생성하고 아래 내용을 그대로 복사하여 붙여넣으십시오.

version: '3.8'

services:

ollama:

image: ollama/ollama

container_name: ollama

ports:

- "11434:11434"

volumes:

- ./ollama:/root/.ollama

restart: unless-stopped

open-webui:

image: ghcr.io/open-webui/open-webui:main

container_name: open-webui

ports:

- "8080:8080"

environment:

- 'OLLAMA_BASE_URL=http://ollama:11434'

depends_on:

- ollama

restart: unless-stopped

volumes:

- ./webui:/app/backend/data

Docker Compose 실행하기#

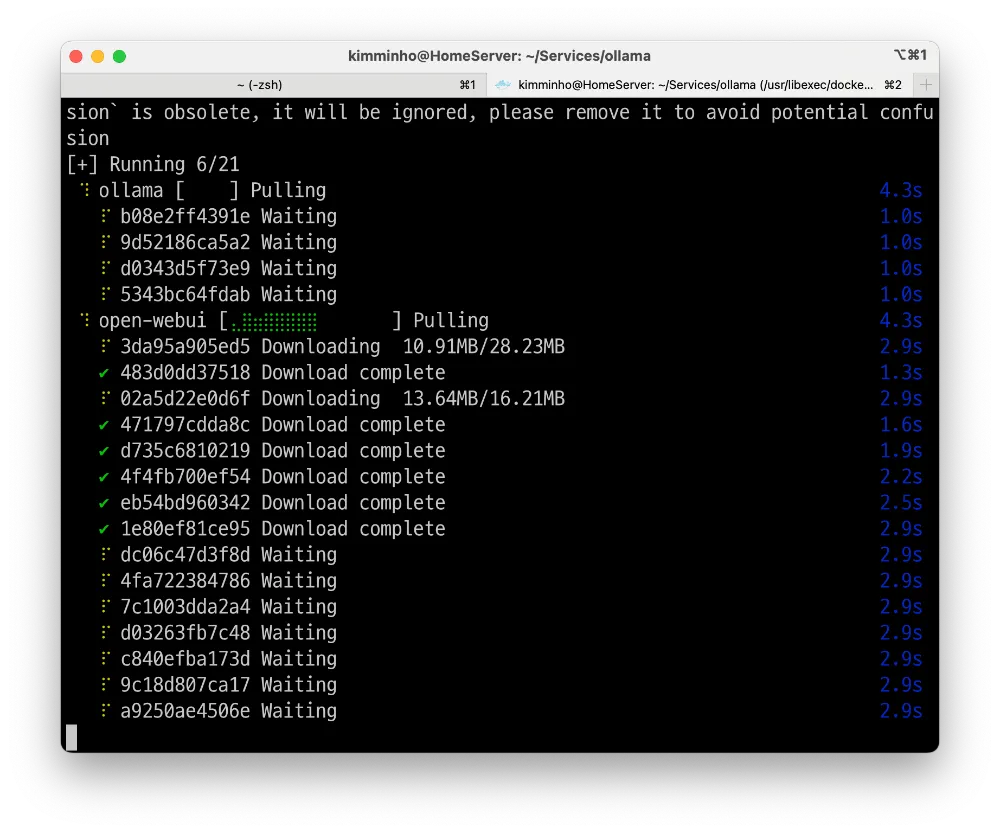

docker-compose.yml 파일을 저장했다면, 터미널을 열고 해당 파일이 있는 폴더로 이동한 뒤, 아래 명령어를 입력하여 실행하십시오.

docker compose up -d

이 명령어는 백그라운드에서(-d) 필요한 이미지를 내려받고 컨테이너를 생성 및 실행합니다. 인터넷 속도에 따라 몇 분 정도 소요될 수 있습니다.

나만의 ChatGPT, 직접 사용해보기#

설치가 성공적으로 완료되었다면, 이제 나만의 AI와 대화할 시간입니다.

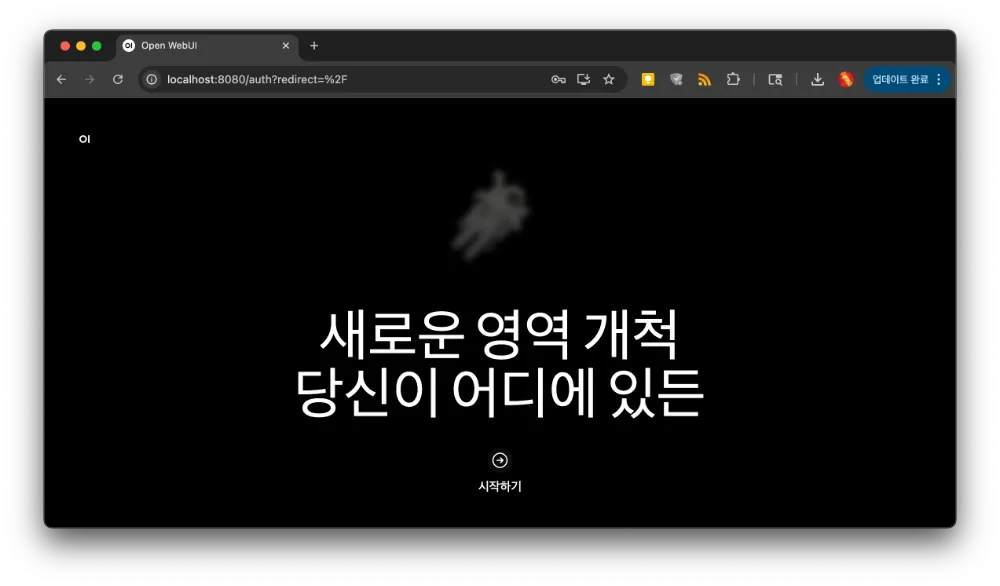

웹 인터페이스 접속하기#

웹 브라우저를 열고 주소창에 http://localhost:8080 을 입력하여 접속합니다. Open WebUI 초기 화면이 나타나면, 간단한 가입 절차를 거쳐 로그인하십시오.

언어 모델 다운로드하기#

처음 접속하면 사용할 수 있는 AI 모델이 없습니다. 우리가 직접 사용할 모델을 내려받아야 합니다.

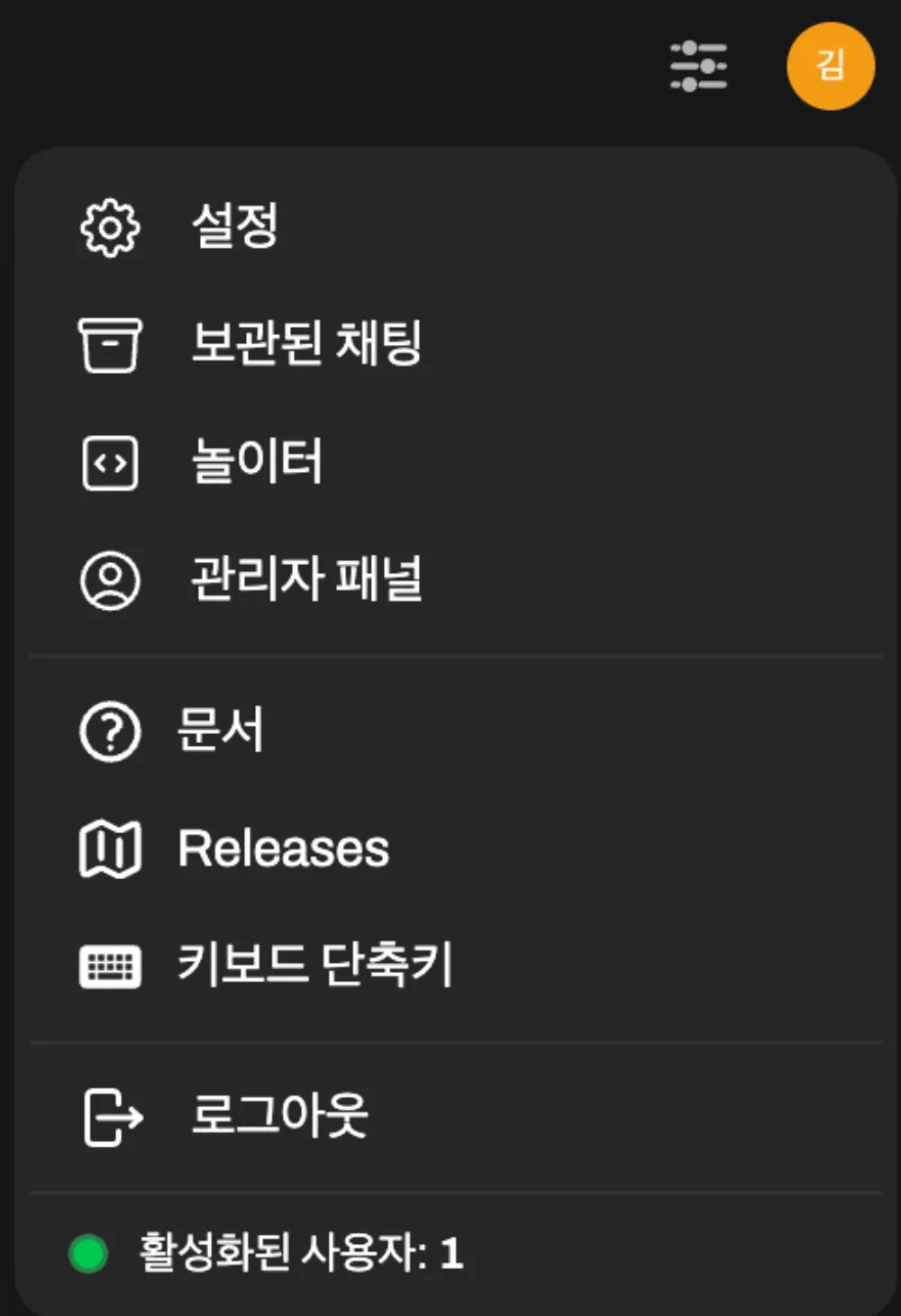

Open WebUI 화면 우측 상단의 계정 아이콘을 클릭하고, ‘관리자 패널’ 메뉴로 이동합니다.

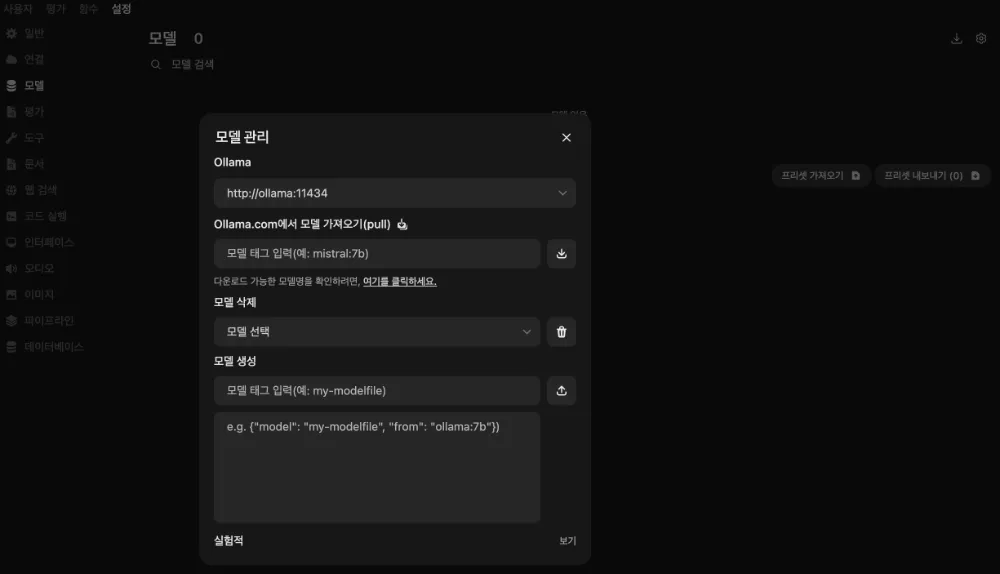

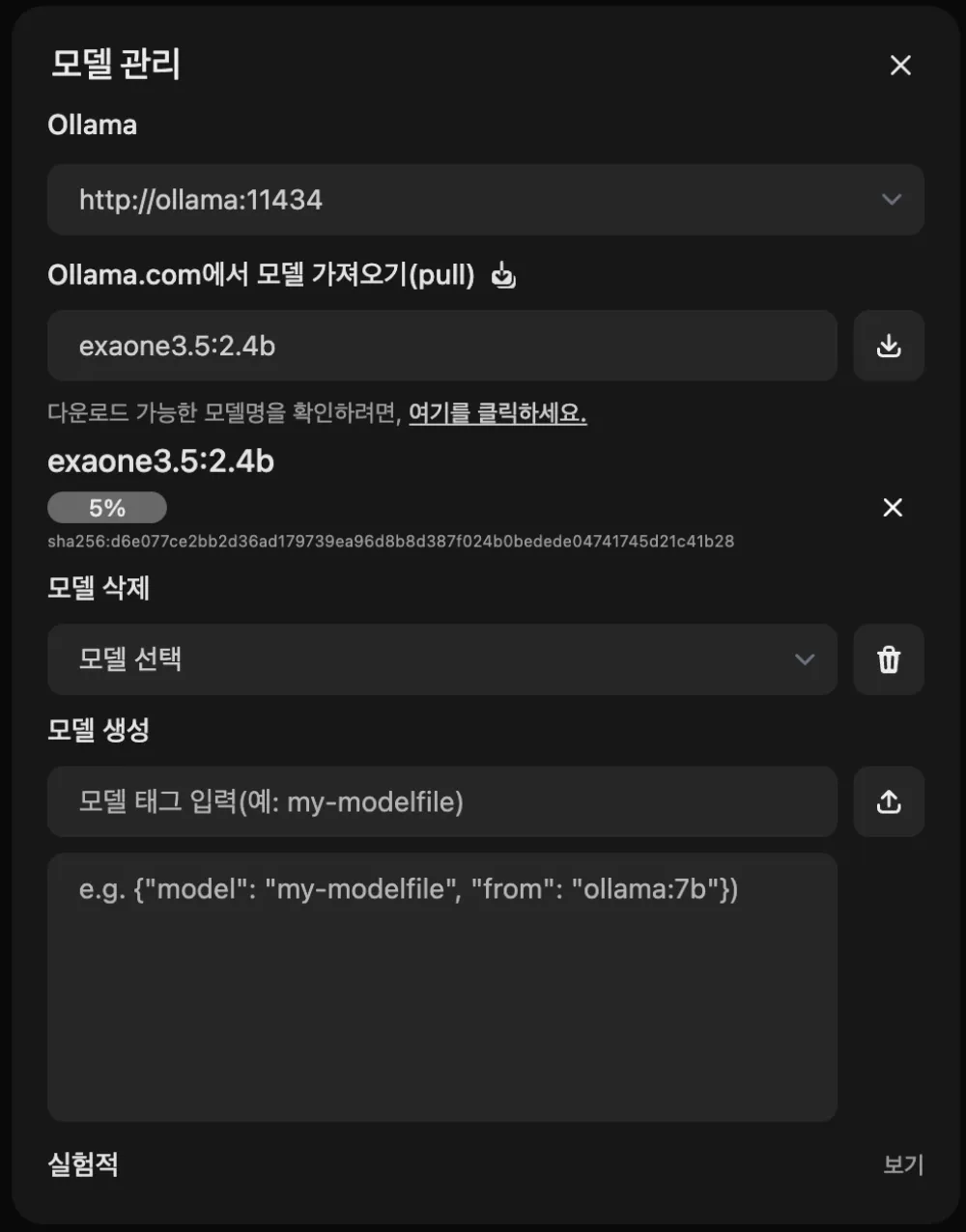

설정 - 모델 - 모델 관리하기 - ‘Ollama.com에서 모델 가져오기(pull)’ 입력창에 원하는 모델 이름을 입력하고 옆의 다운로드 버튼을 클릭합니다. 처음 시작하는 분들께는 범용적으로 사용하기 좋은 llama3:8b 모델 이나 LG에서 만든 exaone3.5:7.8b 모델을 을 추천합니다.

다운로드가 시작되며, 모델 크기에 따라 시간이 걸릴 수 있습니다.

대화 시작하기#

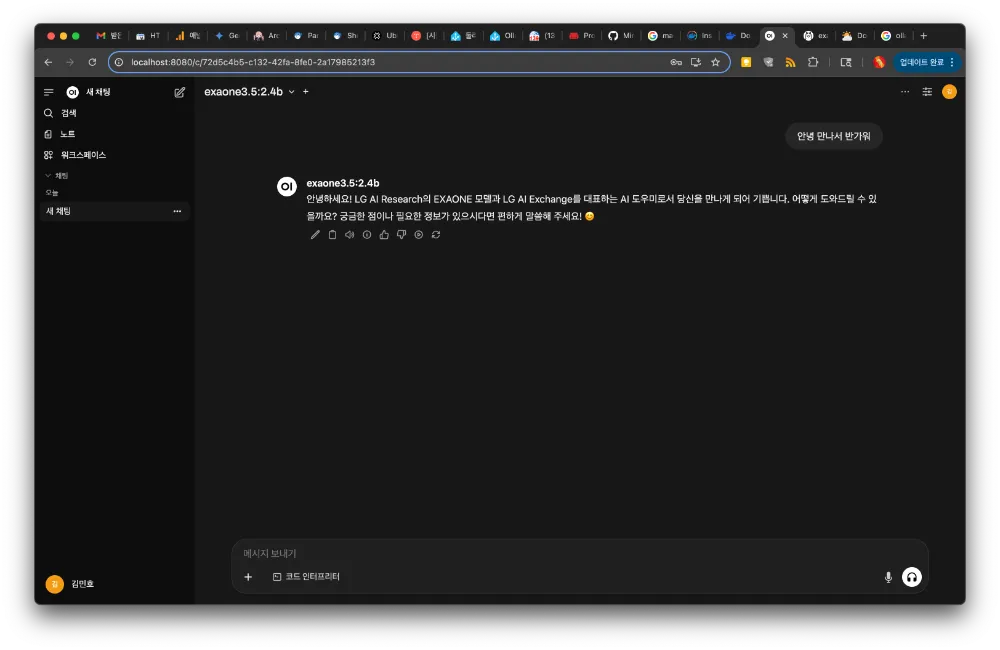

모델 다운로드가 완료되면, 이제 모든 준비가 끝났습니다. 메인 화면으로 돌아와 하단의 채팅창에 궁금한 것을 질문하거나 원하는 대화를 시작해 보십시오. 여러분의 컴퓨터에서 실행되는 나만의 AI가 즉시 답변을 생성해 줄 것입니다.

마무리하며#

지금까지 Docker Compose를 사용하여 Ollama와 Open WebUI를 설치하고, 직접 AI 모델을 내려받아 대화하는 전 과정을 함께했습니다. 생각보다 간단하지 않으셨나요? 이제 여러분은 외부 서비스에 의존하지 않는, 완벽히 독립적인 나만의 AI 비서를 갖게 되었습니다.

참조

- Ollama 공식 페이지: https://ollama.com/

- Open WebUI GitHub 저장소: https://github.com/open-webui/open-webui

- Docker 공식 문서: https://docs.docker.com/